AI begon groot – net als het mainframe

Dat is eigenlijk geen verrassing. Veel baanbrekende technologieën starten met massiviteit en complexiteit. De eerste stoommachines vulden hele fabrieken, de eerste elektriciteitscentrales waren kathedralen van staal en koper en de eerste computers vulden complete kantoren. Radio’s, televisies en mobiele telefoons begonnen als logge monumenten van techniek, totdat miniaturisering de sprong naar massaal gebruik mogelijk maakte.

Bij AI zien we dezelfde cyclus. De eerste taalmodellen moesten gigantisch zijn: enorme datacenters, miljarden parameters, astronomische kosten. Maar nu die eerste brute sprong is gemaakt, dringt de echte vraag zich op: moet een taalmodel eigenlijk wel álles weten? Of worden juist kleinere, gespecialiseerde modellen de nieuwe norm? Die verschuiving is al volop gaande – en het voelt als een oude les die terugkomt.

De terugkeer van specialisatie

In de jaren negentig waren kennissystemen hip. Strak afgebakend, rule-based en domeinspecifiek. Niet uit schoonheidsoverwegingen, maar uit pure noodzaak: hardware was schaars, rekenkracht duur, een alleskunner was (nog) ondenkbaar. Achteraf bleek die beperking een zegen: specialisatie maakte systemen overzichtelijk, uitlegbaar en betaalbaar.

Vandaag gebeurt hetzelfde, maar nu met neurale netwerken in plaats van regels. Wat vroeger een gespecialiseerd kennissysteem was, is nu een compact AI-model van een paar honderd megabyte dat verrassend veel kan, een alleskunner. Omdat de rekenkracht er eindelijk wél is.

De ontwikkeling lijkt op de luchtvaart toen de gebroeders Wright een lichtgewicht 10 pk-motor in hun Flyer schroefden. Het liftprincipe van vleugels was door van Bernoulli decennia eerder beschreven. Maar pas toen er voldoende compacte power beschikbaar kwam, kon het echt vliegen.

De massieve AI en taal modellen van 2023–2025 waren onze Wright Flyer: het bewijs dat het kán. Omdat we de compacte energie eindelijk in onze datacenters hadden. Die fase ligt intussen achter ons en nu pas begint de echte evolutie: miniaturisering, specialisatie en decentralisatie.

De opmars van het kleine

Kleine modellen worden krachtig genoeg om op een smartphone of zelfs een IoT-sensor te draaien en leveren voor de meeste praktische taken resultaten die nauwelijks onderdoen voor de allergrootste reuzen. Het datacenter verdwijnt niet, maar het is niet langer het centrum van de intelligentie. Kunstmatige intelligentie is zich decentraal aan het ontwikkelen en verspreiden.

Net zoals wifi ooit een luxe-extra was – alleen in de lobby van het hotel – wordt het nu simpelweg overal verwacht. Op dezelfde wijze nestelt AI zich nu daar waar de data ontstaat: in auto’s voor predictive safety en in drones voor navigatie. Of in beveiligingscamera’s voor intrusion detection, in fabrieksmachines voor predictive maintenance en in routers voor anomaly detection.

Het wordt embedded intelligence – net zo onzichtbaar en vanzelfsprekend als de tientallen algoritmes die vandaag al je auto stabiliseren. Neem branddetectie in moderne gebouwen: een piepklein model analyseert rook, hitte en geluid lokaal, reageert binnen milliseconden en verbruikt amper energie. Geen cloud-latency, geen datarisico. Maar ook geen mee-kijkers en data-dieven.

De opkomst van modulaire AI

Tegelijkertijd ontstaat er een modulaire AI-architectuur. In plaats van één generalistische alleskunner komt er een ecosysteem van specialistische modellen, bijvoorbeeld voor juridische naleving of medische triage. Of voor industriële procescontrole, specifieke cybersecurity of voor energie-optimalisatie. Ze doen per model minder, maar wat ze doen, doen ze véél beter.

Rond 2030 zit een Neural Processing Unit (NPU) standaard in elk apparaat. Richting 2040 heeft vrijwel elk stuk hardware zijn eigen micro-AI van enkele miljoenen parameters: specifiek getraind op één taak, zuinig met energie en volledig autonoom. Net zoals GPU’s ooit niche waren en nu overal in zitten, wordt embedded AI de nieuwe normaal. Stel je een netwerk voor waarin autonome mini-AI’s op switch-niveau verdacht verkeer herkennen zonder dat er ook maar één pakketje de cloud raakt. Sneller, veiliger, goedkoper.

Apple’s Apple Intelligence in de iPhone 16-serie (2024–2025) en de nieuwe MacBooks met M4 draaien vrijwel alle on-device features – van schrijven en beeldbewerking tot Siri-begrip – met modellen van 3 tot 30 miljard parameters lokaal, waarbij alleen de allermoeilijkste taken nog naar Private Cloud Compute gaan.

In 2040 zal AI onder de motorkap wonen

In 2040 praat niemand meer over “een AI-applicatie”, net zomin als we nu zeggen: “dit apparaat heeft internet”. AI zit er gewoon in – altijd aan, vrijwel altijd onzichtbaar. Miljoenen kleine, autonome modellen werken lokaal, wisselen alleen noodzakelijke informatie uit en verbeteren zichzelf binnen hun eigen domein. Iedereen heeft tegen die tijd een device-gebaseerde persoonlijke assistent die heel vertrouwelijk slechts jouw data gebruikt en aanvult. Jouw denkproces en workflow door en door kent. Jou volledige privacy garandeert en alleen bij uitzondering een extern model raadpleegt.

Het is de digitale evolutie van de persoonlijke router: klein, lokaal, volledig in eigen beheer. De grote modellen blijven als clouds en datalakes bestaan, maar ze worden infrastructuur – net als elektriciteitscentrales. De echte innovatie gebeurt van onder de motorkap: van de miljoenen kleine AI’s die op miljarden devices overal draaien. Intelligentie verspreidt zich, wordt kleinschaliger en versterkt daardoor het geheel. Decentralisatie wordt de nieuwe macht.

In slimme thermostaten en beveiligingscamera’s van fabrikanten als Nest en Arlo, die sinds begin 2025 een compact 200 MB-model aan boord hebben, wordt gezichtsherkenning en abnormaal gedrag lokaal verwerkt om bijvoorbeeld valpartijen bij ouderen te detecteren of ongeautoriseerde toegang te blokkeren, allemaal zonder directe internetverbinding en met minimale batterijbelasting.

Slot

AI begon zijn zegetocht groots en gigantisch omdat die eerste technische sprong brute kracht vereiste. Maar nu die stap gezet is, volgt de natuurlijke evolutie: miniaturisering, specialisatie en decentralisatie. Wat ooit alleen in kathedraalachtige datacenters paste, past straks op een chip kleiner dan een postzegel. En zoals bij elke grote technologische transformatie geldt: de echte massa-adoptie begint pas wanneer het grootse uiteenvalt in het kleine.

Niet in de cloud, maar onder de motorkap – daar woont de toekomst van AI.

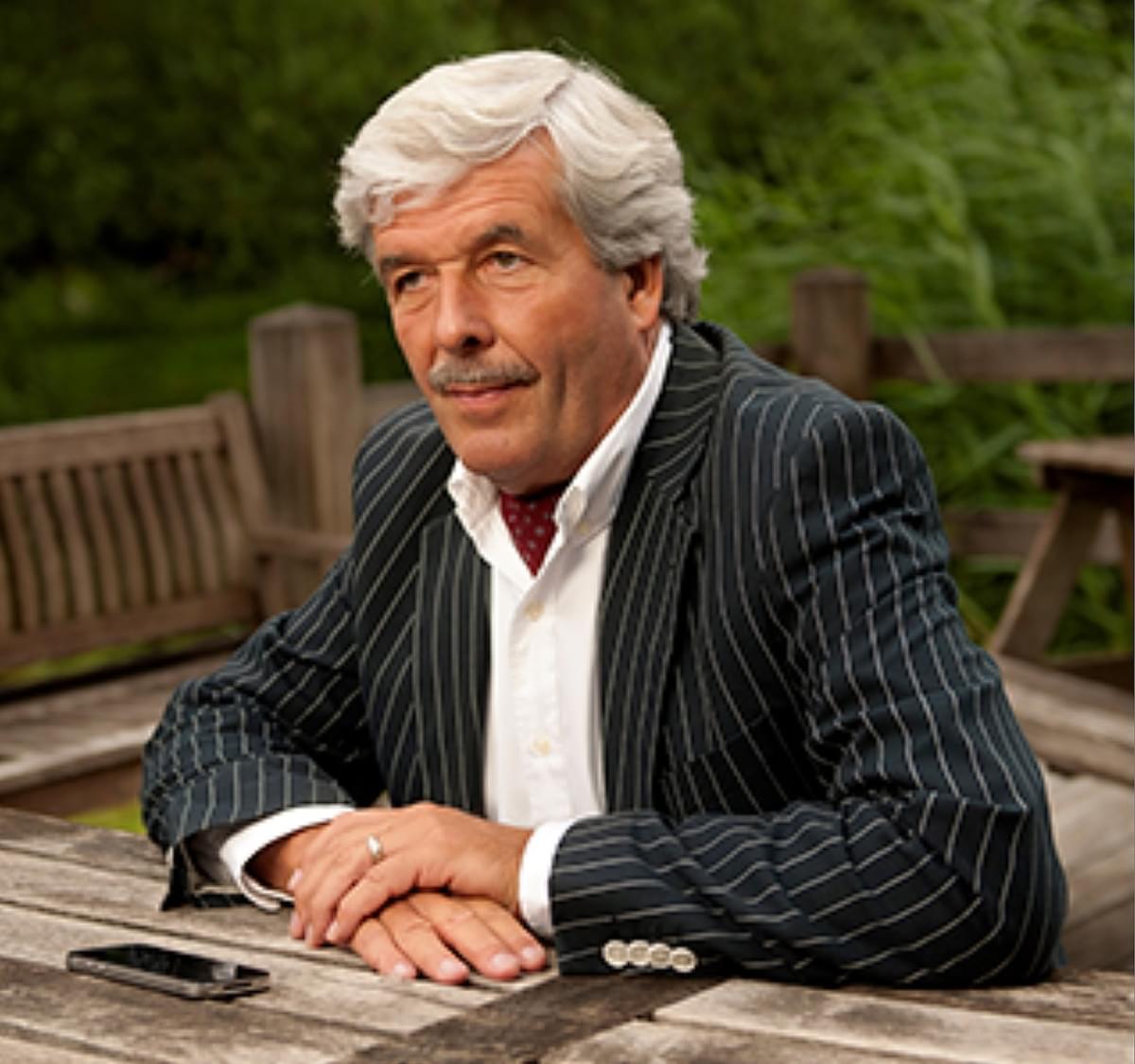

Door: Hans Timmerman (foto)